Orwell estaría orgulloso.

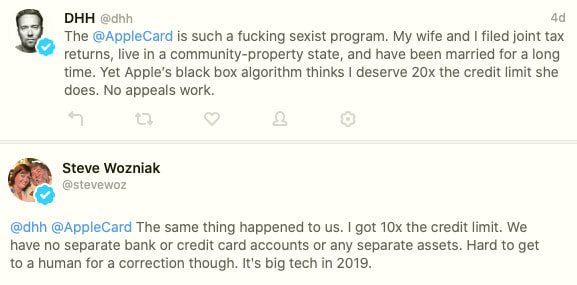

El famoso cofundador de Apple y hacker Woz y el creador de Ruby on Rails David Hansson han compartido en Twitter una experiencia similar –aunque les sucedió a cada uno por su lado– respecto a la tarjeta de crédito «diferente» de Apple, la Apple Card. Hansson califica a la tarjeta Apple Card de «sexista» porque cuando su mujer y él la solicitaron les ofreció condiciones distintas en cuanto a límites de crédito e intereses sin razón aparente.

A Hansson, que tiene comprada la casa con su mujer a medias y pagan los impuestos de forma conjunta a medias (están casados) la tarjeta le ofrece un límite 20 veces más alto a él que a ella para sus compras. En el caso de Wozniak y su mujer la diferencia del límite en la Apple Card es 10 veces mayor, con un 5% menos –o más, según de qué lado se mire– de interés / APR (lo que en España sería el TAE). Woz se queja además de lo difícil que resulta hablar con algún humano que pueda entender y resolver el problema; Hansson por su parte lo consiguió.

Antes de que alguien lo apunte, Woz y su mujer mantienen en el sentido crediticio una «igualdad perfecta»: no tienen cuentas separadas, ni tarjetas crédito separadas ni propiedades separadas. Woz explicó además que ya no se considera súper rico porque donó toda su fortuna hace años; pidió un crédito para comprar una casa y se buscó un nuevo trabajo de conferenciante porque era lo que le apetecía.

El Goldman Sach Bank, que es uno de los socios de Apple para la Apple Card, ha explicado que hay muchos factores en su algoritmo de scoring, incluyendo el «historial crediticio» que pueden hacer que incluso dos personas aparentemente iguales de la misma familia obtengan resultados distintos en una solicitud. Según Bloomberg, las autoridades de Nueva York van a investigar al Grup Goldman Sachs para confirmar si su algoritmo –secreto– discrimina o no a las mujeres. En The Verge también lo cuentan: Apple’s credit card is being investigated for discriminating against women.

Hay quien ha apuntado a que el problema podría estar en que aunque el algoritmo no esté programado para tener en cuenta el género de las personas que solicitan la tarjeta —que en mi opinión sería lo más probable– de algún modo la inteligencia artificial que se usa para asignar los límites y tasas de interés haya aprendido a distinguir entre hombres y mujeres a partir de otra información, sin que se sepa todavía por qué. Inquietante.

§

Por otro lado Charles Rollet escribió un artículo para IPVM en el que se habla de una cámara de vigilancia que permite diferenciar etnias chinas, en concreto identificar chinos uighures, a los que califican como «una de las minorías más perseguidas del mundo».

Aunque la imagen original de los tuits no era más que un «ejemplo ilustrativo» y el fabricante de la cámara (Hikvision) no la utilizaba en su web, tras la publicación parece ser que han retirado la página web de la cámara en cuestión y no responden preguntas.