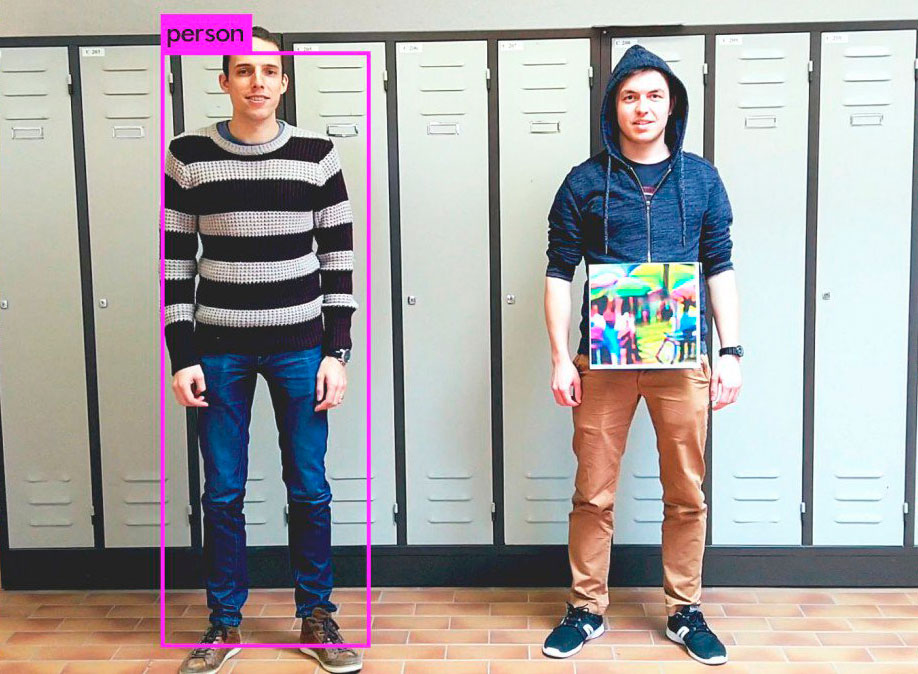

La hoja de papel con un dibujo que cuelga del jersey del sujeto de la derecha consigue engañar al popular algoritmo de visión artificial y clasificación YOLO haciendo que no detecte a esa persona como a una persona. Es una forma de engañar a los algoritmos de las cámaras de seguridad, generando lo que se conoce como muestra «adversarial» o «antagónica» que confunde al algoritmo. Lo han desarrollado investigadores de la Katholieke Universiteit Leuven (Bélgica).

Tradicionalmente lo que se hace en estos engaños es modificar algunos píxeles o trozos de otras imágenes («parches») sobre una imagen digital, de modo que la imagen resultante «confunda» al algoritmo. Pero algunas de estas técnicas sólo funcionan con imágenes concretas o estando previamente digitalizadas.

Este truco en particular funciona en tiempo real y especialmente con personas, que son un tipo de imágenes fácilmente clasificables debido a la gran variedad de muestras con que se suelen entrenar las redes neuronales. Podría decirse que es una especie de «truco para hacer desaparecer personas completas» que engaña a los algoritmos más capaces precisamente en «detectar personas».

Se pueden leer los detalles aquí: Fooling automated surveillance cameras: adversarial patches to attack person detection (arXiv). No es el único ejemplo de esto tipo de imágenes adversariales, algo que hace que las personas confundan imágenes sintéticas como si fueran imágenes verdaderas y, como en este caso, a las máquinas haciéndolas no reconocer imágenes auténticas como lo que son.

(Vía MIT Technology Review.)