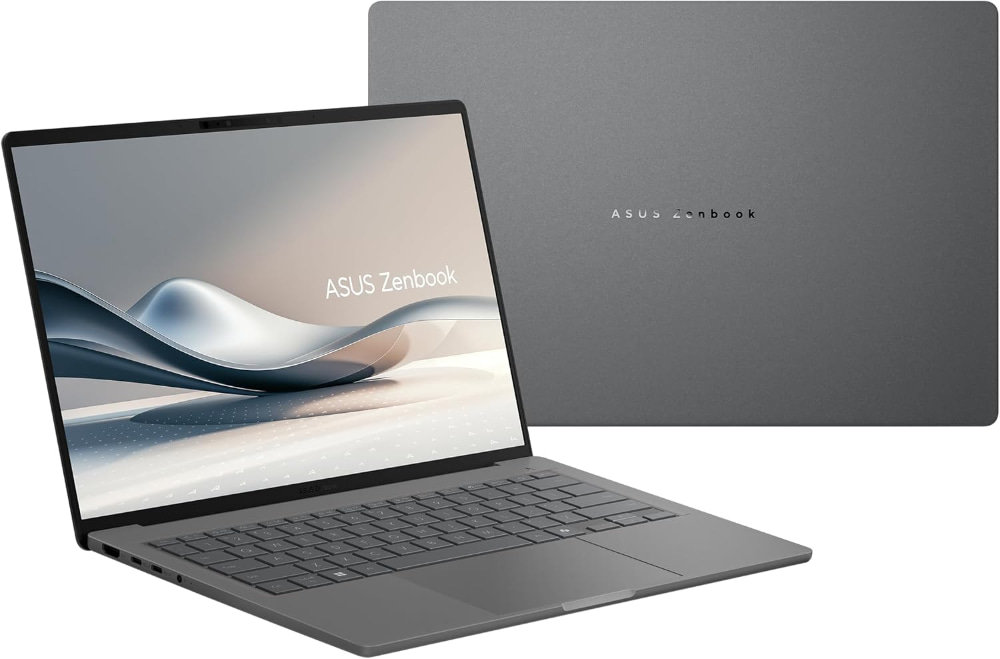

El Asus Zenbook A14 en color Gris Islandia – Asus

He estado poniendo a prueba un Asus Zenbook A14 estas últimas semanas. Y he de decir que me ha sorprendido muy positivamente, en especial en lo que se refiere a la duración de la batería y a su peso. O más bien a su falta de peso.

El Zenbook A14 en la configuración que utilicé yo monta un procesador Snapdragon® X X1-26-100 Oryon con caché de 30 MB, hasta 2,97 GHz, 8 núcleos, y 8 subprocesos); una NPU –acelerador de IA– Qualcomm® Hexagon™ hasta 45 TOPS; y una tarjeta gráfica Qualcomm® Adreno™.

Tal y como me lo enviaron venía con 32 GB de RAM LPDDR5X y un SSD M.2 NVMe™ PCIe® 4.0 de un TB, aunque la configuración mínima son 16 GB de RAM y un SSD de 512.

Todo esto montado en un chasis que mide 31,07×21,39 centímetros de ancho y de fondo y 1,59 centímetros en su parte más gruesa –dónde está la bisagra– que bajan hasta los 1,59 en su parte frontal.

En el lateral derecho hay un puerto USB A 3.2 de 2.ª generación; en el izquierdo hay un conector HDMI 2.1 TMDS, dos puertos USB C 4.0 con soporte para pantalla y entrega de energía con una velocidad de datos de hasta 40 Gbps; y un jack de audio de 3,5 mm. Wi-Fi 6E (802.11ax) y Bluetooth® 5.3 completan las opciones de conectividad del A14.

Abierto muestra una pantalla OLED de 14 pulgadas con resolución WUXGA (1.920×1.200) en formato 16:10 con retroiluminación LED y 60Hz tasa de refresco y tiempo de respuesta de 0,2 milisegundos. En la parte superior central va una cámara HD con función IR compatible con Windows Hello, lo que quiere decir que puede utilizar tu cara para desbloquear el ordenador. La pantalla se puede abrir con un dedo, algo a mi modo de ver siempre de agradecer en un portátil.

El teclado, retroiluminado en blanco, es de tipo chicle, con un recorrido de tecla de 1,3 mm. El trackpad, de precisión, según Asus, mide mide 127×78 mm. Se trata de un touchpad de vidrio, suave al tacto, con botones integrados y soporte para gestos multitáctiles avanzados, como ajuste de volumen y brillo mediante deslizamientos en los bordes.

Andan también por ahí tres micrófonos y unos altavoces.

Y he dejado el peso para el final porque como decía arriba, me ha parecido una de las características más sorprendentes de este portátil. Son sólo 985 gramos. Eso lo hace tan ligero que el día que lo saqué de la caja creí que me habían enviado un modelo de exposición vacío. Pero no, venía completito con todas sus cosas.

Me sorprendió el día en que lo saqué de la caja y me seguía sorprendiendo el día en que lo empaqueté para enviarlo de vuelta. Y ahora mi ordenador habitual, un MacBook Air M2, con su 1,24 kg de peso, casi me parece pesado.

Eso es en gran medida gracias al material del que está construido, que aunque a primera vista pueda parecer plástico en realidad es de un material que Asus ha bautizado como Ceraluminio y que es una aleación de magnesio y aluminio. Dicen que es anti desgaste, anti arañazos y que no se mancha. Las dos primeras cosas me las puedo creer; lo de las manchas pues bueno, puedo dejarlo en que quizás se manche menos que otros materiales. Pero mancharse se mancha, aunque es fácil de limpiar.

Seguir leyendo: «Ponemos a prueba el Asus Zenbook A14, un portátil impresionantemente ligero y que tampoco anda nada mal de autonomía y prestaciones»