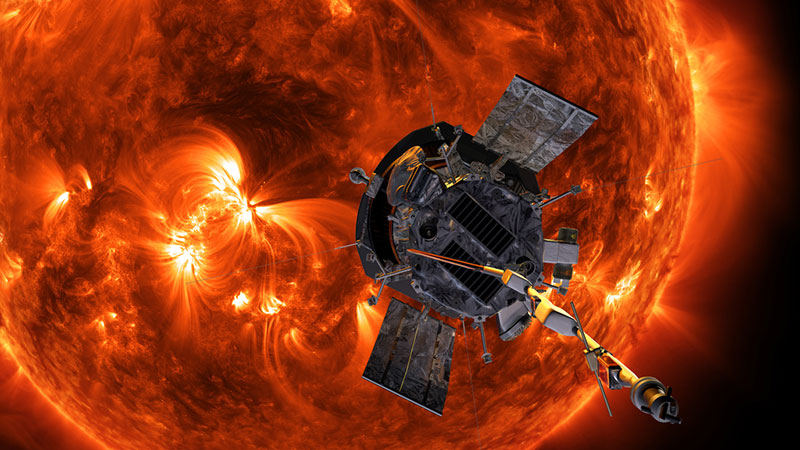

La PSP mirando hacia el Sol – NASA/Johns Hopkins APL/Steve Gribben

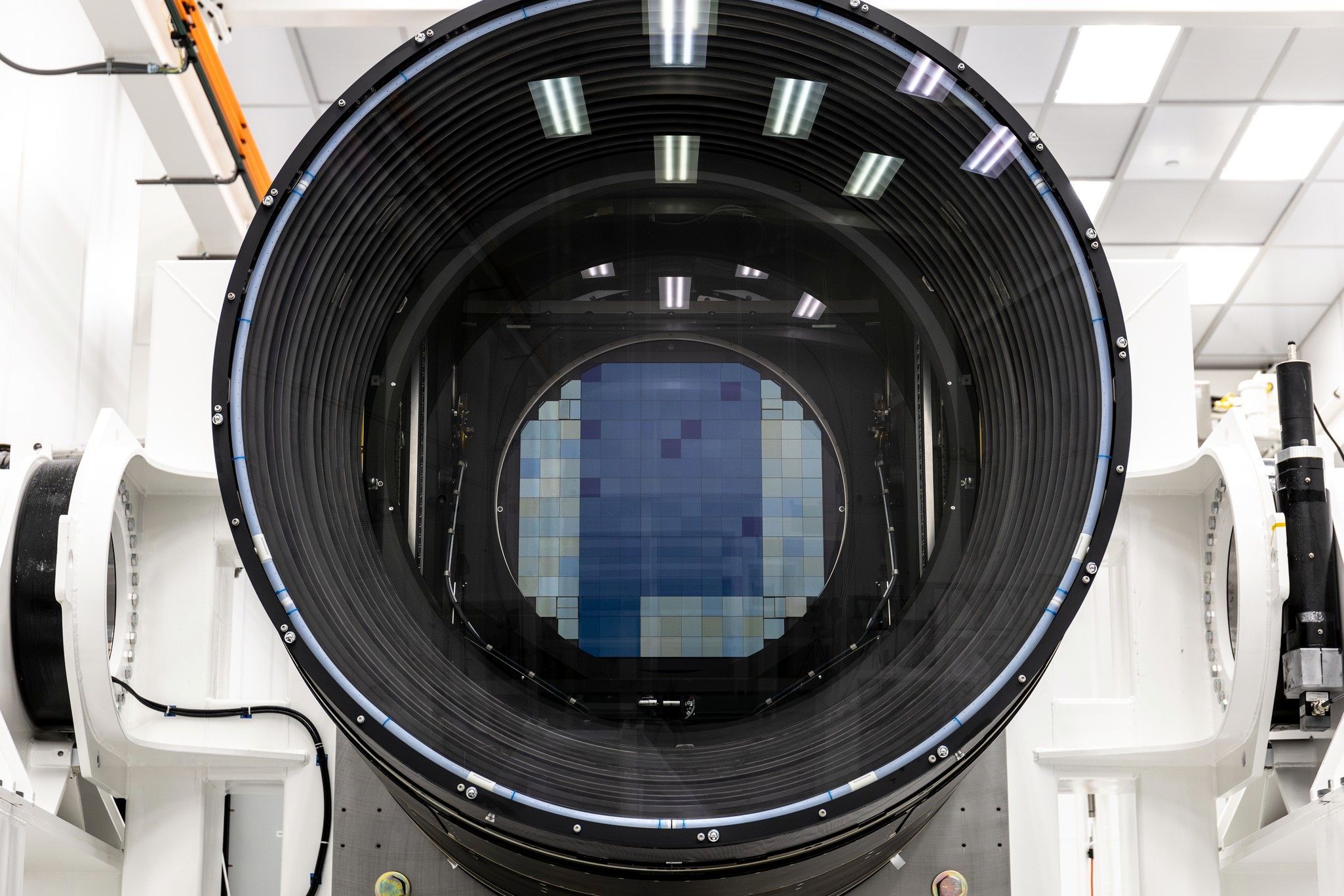

Hace unos días la Parker Solar Probe de la NASA informaba al control de la misión de que había sobrevivido al vigésimo cuarto perihelio de su órbita alrededor del Sol. Es el punto de ella en el que más se aproxima a nuestra estrella, en el que se coloca a tan sólo 6,2 millones de kilómetros de su superficie. Eso marca el fin de su misión, pues ya ha cumplido todos los objetivos previstos.

Lanzada el 13 de agosto de 2018 su objetivo era introducirse en la corona, para estudiarla con más detalle que nunca hasta ahora. Para ello utilizó varias asistencias gravitacionales de Venus hasta que en su sobrevuelo del planeta del seis de noviembre de 2024 la órbita quedó establecida en la actual, de 6,2×68 millones de kilómetros sobre la superficie del Sol.

Así la PSP se convertía en la nave espacial que más se ha acercado nunca al Sol. Y cuando está en el perihelio de su órbita, en el que alcanza los 687.000 kilómetros por hora, es también la más rápida. Esta velocidad es, junto con su escudo térmico, lo que le permite sobrevivir tan cerca del Sol. Salvando todas las distancias, es como cuando, aunque tengas el horno a 200 grados, metes algo en él. Mientras no toques las paredes internas si lo haces lo suficientemente rápido no te quemarás; la PSP no se quema porque la Corona es muy poco densa aunque está a entre uno y dos millones de grados Celsius.

La Parker Solar Probe y sus instrumentos están diseñados para que nos proporcionen información más detallada que nunca sobre nuestro Sol, cuyo estado llega a afectar a la Tierra y a otros astros. Está estudiando cómo se mueven la energía y el calor a través de la atmósfera del Sol y lo que acelera el viento solar y las partículas de energía solar.

La idea es que con los datos que obtengamos gracias a ella podremos entender mejor el clima espacial y protegernos mejor contra él; no hay que olvidar que el viento solar afecta a la magnetosfera terrestre.

Dos de las cosas que ha podido observar son inversiones repentinas del campo magnético del viento solar, conocidas como retrocesos magnéticos, que generan calor que contribuye a aumentar la temperatura de la corona; y ondas de Alfvén, un fenómeno teorizado en 1942 por Hannes Alfvén que es el que causante principal de la enorme temperatura de la corona en comparación con la de la superficie, que «apenas» está a unos 5.500 grados Celsius. También ha sido la primera sonda en detectar una inestabilidad Kelvin-Helmholtz en una eyección de masa coronal, algo que hace tiempo que sospechábamos que debía pasar pero que nunca habíamos visto.

Y si la Parker Solar Orbiter nos está permitiendo ver el Sol desde más cerca que nunca la Solar Orbiter de la Agencia Espacial Europea nos está permitiendo verlo desde nunca lo habíamos visto antes, pues acaba de conseguir las primeras imágenes de su polo sur que hayamos visto jamás.

En cualquier caso el perihelio de la PSP del pasado día 19 ha sido el tercero a 6,2 millones de kilómetros. Pero no será el último. De hecho se producirán otros dos más este año. Y como la mecánica orbital es la que es, la PSP seguirá girando alrededor del Sol durante los próximos millones de años. Lo que no podrá hacer es variar más su órbita ya que después del sobrevuelo de Venus del pasado mes de noviembre ya siempre estará más cerca del Sol que el planeta.

Así que por ahora, y suponiendo que la administración Trump no le de el matarile, la PSP seguirá observando el Sol órbita tras órbita mientras tenga combustible de maniobra para mantener sus antenas orientadas hacia la Tierra.

Por cierto que el nombre de la sonda es un homenaje a Eugene Newman Parker, un astrofísico estadounidense, no a la consola de Sony. En la década de los 50 Parker predijo la existencia del viento solar y la forma que tendría el campo magnético del Sol en el sistema solar exterior, hoy conocida como espiral de Parker. También propuso, pero ya en 1987, que la elevadísima temperatura de la corona solar podía ser producida por innumerables fulguraciones solares en miniatura.

Fue la primera vez en la historia de la NASA que una misión ha recibido el nombre de alguien todavía vivo en el momento de su lanzamiento. Aunque Eugene Parker falleció el 15 de marzo de 2022, con lo que aunque no vio como la sonda alcanzaba su distancia mínima al Sol sí que pudo enterarse de cómo iba cumpliendo la misión sin mayore problemas hito tras hito.

Relacionado,